今天分享一篇知乎高赞文章,作者是张俊林老师。

图片

图片

读完收获很多,能帮大家更好地理解、学习大模型。原文有2.8w字,我提炼了核心要点,阅读需要10min。

ChatGPT的出现给很多人带来了惊喜和醒悟。有人惊喜地发现大型语言模型(LLM)的效果如此出色,而有人则意识到我们对LLM的认知和发展理念距离世界先进水平还有很大差距。我是既惊喜又醒悟的一员,也是典型的中国人,善于自我反思。因此,我开始反思,并将这篇文章作为反思的结果。

我认为,AI target=_blank class=infotextkey>OpenAI在LLM的理念和相关技术方面领先于国外的google和DeepMind大约半年到一年的时间,领先国内大约两年左右。在LLM这个问题上,梯队很明显,Google应该排在第二位,最能体现Google技术眼光的是PaLM和Pathways,推出时间大约在2022年2月到4月之间。同一时期,OpenAI推出的是InstructGPT,从这里可以看出Google和OpenAI的差距。至于为什么这么说,你看了后面的内容就能理解。DeepMind之前的重点一直在强化学习攻克游戏和AI for science等方面,对LLM的关注比较晚,大约是在2021年才开始重视这个方向,目前仍在追赶状态。Meta在LLM上的关注更少,重点一直不在LLM上,目前也在努力追赶。这些机构是目前做得最好的,即便如此,国内的差距也是可以理解的。至于OpenAI关于LLM的理念是什么,我会在本文的最后一部分谈谈我的认知。

本文试图回答一些问题:ChatGPT是否带来了NLP乃至AI领域的研究范式转换?如果是,那会带来怎样的影响?LLM从海量数据中学到了什么知识?LLM又是如何存取这些知识的?随着LLM规模逐步增大,会带来什么影响?什么是In Context Learning?为什么它是一项很神秘的技术?它和Instruct又是什么关系?LLM具备推理能力吗?思维链CoT又是怎么做的?等等。通过阅读本文,您将对这些问题有一个答案。

在谈到LLM技术现状之前,我先宏观地谈一下我心目中的研究范式转换问题,这样我们才能更清晰地理解具体技术的变化。

如果我们回顾NLP领域的技术发展,可能会发现两次大的研究范式转换。第一次转换是从深度学习到两阶段预训练模型,时间跨度大约是2013年至2020年。在Bert和GPT模型出现之前,NLP领域主要依赖于深度学习模型,其中核心技术是改进的LSTM和CNN模型以及Sequence to Sequence+Attention的总体技术框架。然而,深度学习在NLP领域的应用并没有取得很大的成功,主要原因是数据量的限制和特征抽取器的表达能力不够强。Bert和GPT模型的出现改变了这一现状,引领了NLP领域的技术转变。这种转变带来了两个影响:一是中间任务的消亡,二是不同研究方向技术路线的统一。

第二次转换是从预训练模型走向通用人工智能(AGI),时间跨度大约是2020年至今。ChatGPT是这次转换的关键节点,它实现了理想LLM模型的接口层,让LLM适应人类的习惯命令表达方式。这对于提高LLM的易用性和用户体验至关重要。这次转换将进一步推动LLM模型的发展,纳入更多的研究领域,逐步实现通用人工智能。

在这个背景下,很多NLP子领域将不再具备独立研究的价值,因为LLM模型可以通过吸收更多的领域知识来解决这些问题。同时,更多NLP之外的研究领域也将被纳入LLM技术体系,成为通用人工智能的一部分。图像处理和多模态任务是其中的一个自然选择。

总的来说,LLM模型的发展趋势是追求规模越来越大的模型,通过增加预训练数据的多样性来涵盖更多的领域知识。人机接口技术也将继续改进,让LLM更好地适应人类的表达方式。这些技术转变将对NLP领域和其他研究领域产生深远影响。

接下来,我们来梳理下GPT 3.0之后LLM模型的主流技术进展。

Transformer是一种强大的特征抽取器,通过预训练过程,它可以学习到丰富的知识。这些知识可以分为语言类知识和世界知识两大类。

语言类知识包括词法、词性、句法、语义等与自然语言理解相关的知识。研究表明,Transformer可以学习各种层次的语言学知识,并且这些知识在模型的不同层次中有所分布。浅层的语言知识如词法、词性、句法等存储在低层和中层,而抽象的语言知识如语义类知识则广泛分布在中层和高层。

世界知识指的是关于真实事件和常识性知识的知识。研究表明,Transformer可以从训练数据中吸收大量的世界知识,并且这些知识主要分布在中层和高层,尤其集中在中层。随着模型层数的增加,LLM可以学习到更多的世界知识。因此,可以将LLM看作是一种以模型参数体现的隐式知识图谱。

对于训练LLM模型所需的数据量,研究表明,对于语言学知识来说,使用1000万到1亿单词的语料就足够了,但要学习事实类知识,则需要更多的训练数据。随着训练数据量的增加,预训练模型在各种下游任务中的效果也会越好。因此,从增量的训练数据中学到的更多是世界知识。

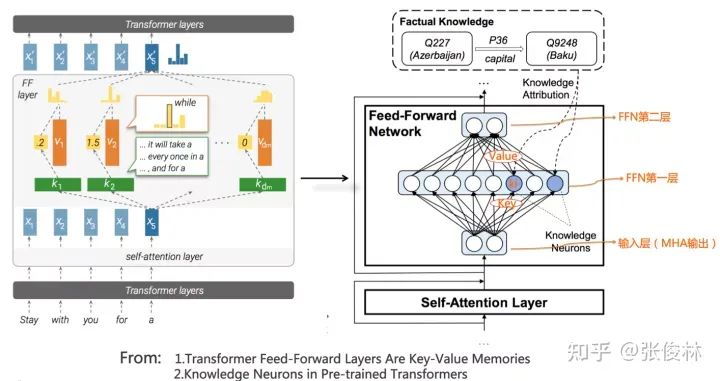

LLM模型将知识存储在Transformer的模型参数中。模型参数由多头注意力(MHA)和前馈神经网络(FFN)两部分组成。MHA主要用于计算单词或知识之间的相关强度,并对全局信息进行集成。而FFN部分存储了具体的知识。一种观点认为,FFN可以看作是一个存储大量具体知识的Key-Value存储器。FFN的第一层是Key层,用于识别输入中的语言或知识模式。第二层是Value层,用于存储与Key层对应的具体知识。FFN的输入层是通过Self Attention得到的整个输入句子的整体信息。FFN的正向传播过程可以看作是通过Key层检测知识模式,然后取出对应的Value,并体现在输出上。

图片

图片

修正LLM模型中存储的知识有几种方法。一种方法是从训练数据的源头进行修正。通过追踪某条知识对应的训练数据源头,可以删除相关的数据源,然后重新预训练整个LLM模型。另一种方法是对LLM模型进行fine-tuning,根据新知识构建训练数据,让LLM模型在这个数据上进行fine-tuning。还有一种方法是直接修改LLM模型参数中存储的知识。这些方法都有各自的优缺点,需要根据具体情况选择合适的方法。

随着LLM模型规模的增大,对于预训练阶段来说,增加训练数据量和模型参数规模是提高模型效果的关键。研究表明,同时增加训练数据量和模型参数规模效果最好。此外,随着模型规模的增大,LLM在不同类型的任务上表现也有所不同。对于知识密集型任务,随着模型规模增大,任务效果越来越好。对于某些任务,随着模型规模的增大,任务效果呈现出U形增长曲线。对于一些任务,LLM具备一种"涌现能力",当模型规模足够大时,任务效果突然出现性能增长。这些现象都需要进一步深入研究。

In Context Learning和Instruct是两种不同的任务描述方式。In Context Learning是通过给出具体示例来描述任务,而Instruct是一种更抽象的任务描述方式。目前的研究表明,LLM可以从给定的示例中学习到Instruct的描述,但是关于LLM是如何实现这种学习的,目前还没有确切的答案。

在增强LLM的推理能力方面,目前的研究主要集中在两个方向。一种是基于Prompt的方法,通过合适的提示语或示例来激发LLM的推理能力。另一种是在预训练阶段引入程序代码,以增强LLM的推理能力。这两种方法可以互相补充,但从长远来看,增加训练数据的多样性和引入代码参与预训练是更为重要的。

基于Prompt的方法在激发LLM模型推理能力方面有着重要作用。可以将其分为三条技术路线。

第一种思路是在问题上追加辅助推理Prompt。这种方法简单直接,但在众多领域都很有效。具体做法是在问题前追加提示语,例如"Let’s think step by step",然后将LLM的输出与问题拼接,再追加提示语"Therefore, the answer is",这样可以大幅增加LLM在各项推理任务中的效果。

第二种思路是基于示例的思维链(Chain of Thought)Prompting。这个方向是LLM推理研究的主要方向。通过给出人工编写的推理示例,详细描述每个推理步骤,让LLM模型学会推理。这种方法可以显著提升LLM模型的推理能力。

第三种思路体现了一种分治算法的思想。将复杂的推理问题分解成若干容易解决的子问题,然后逐步解决子问题,最终推导出整个问题的答案。这种思路类似于分治算法,可能是揭示问题本质、解决LLM复杂推理问题的道路。

此外,加入代码预训练可以显著增强LLM模型的推理能力。通过在预训练过程中加入代码数据,可以提升LLM模型在推理任务中的表现。这可能是因为代码数据中包含了数学类或逻辑推理类的数据,对解决下游数学推理问题有帮助。

总体而言,LLM模型具备推理能力,只是我们需要合适的方法来激发它。未来的研究可以集中在增强LLM的复杂推理能力、探索LLM在NLP之外领域的应用、改进人机交互接口、构建高难度的综合任务评测数据集等方向。此外,还可以研究如何提高LLM模型的训练效率,如稀疏化模型等技术选项。

最后,要注意在复刻类似ChatGPT的模型时,选择合适的预训练模式、引入代码数据进行预训练、注意数据质量和多样性、降低模型规模的同时保持效果、设计易用的人机交互接口等。这些选择将有助于实现强大的LLM模型。