新智元报道

编辑:编辑部

【新智元导读】ChatGPT横空出世后,RLHF成为研究人员关注的焦点。谷歌最新研究提出,不用人类标注,AI标注偏好后,也能取得与RLHF一样的效果。

如果说,RLHF中的「人类」被取代,可行吗?

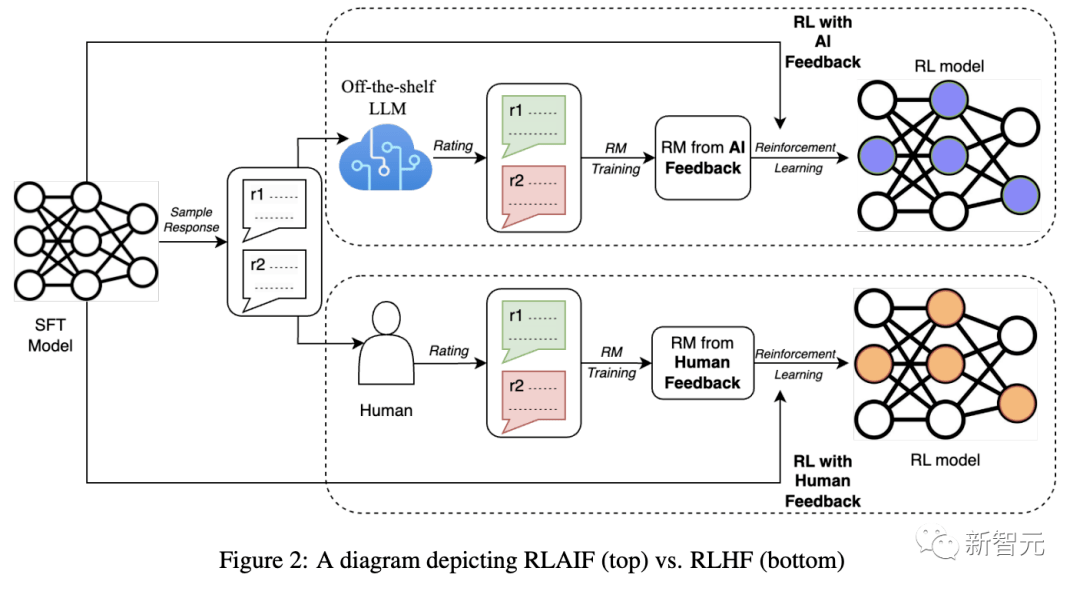

谷歌团队的最新研究提出了,用大模型替代人类,进行偏好标注,也就是AI反馈强化学习(RLAIF)。

论文地址:https://arxiv.org/abs/2309.00267

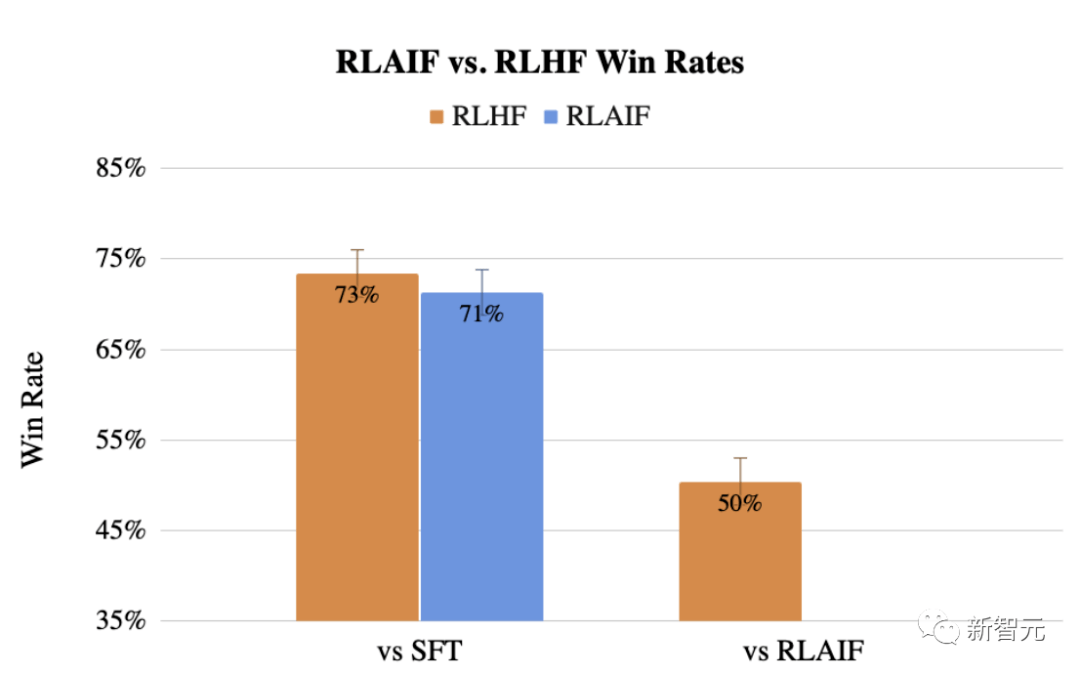

结果发现,RLAIF可以在不依赖人类标注员的情况下,产生与RLHF相当的改进效果,胜率50%。

同时,谷歌研究再次证明了RLAIF和RLHF,比起监督微调(SFT)胜率都超过了70%。

如今,大型语言模型训练中一个关键部分便是RLHF。人类通过对AI输出的质量进行评级,让回应更加有用。

但是,这需要付出很多的努力,包括让许多标注人员暴露在AI输出的有害内容中。

既然RLAIF能够与RLHF相媲美,未来模型不需要人类反馈,也可以通过自循环来改进。

RLHF不需要人类了

当前,RLHF已经成为微调大模型的核心方法,包括ChatGPT、Bard等模型都采用这一范式。

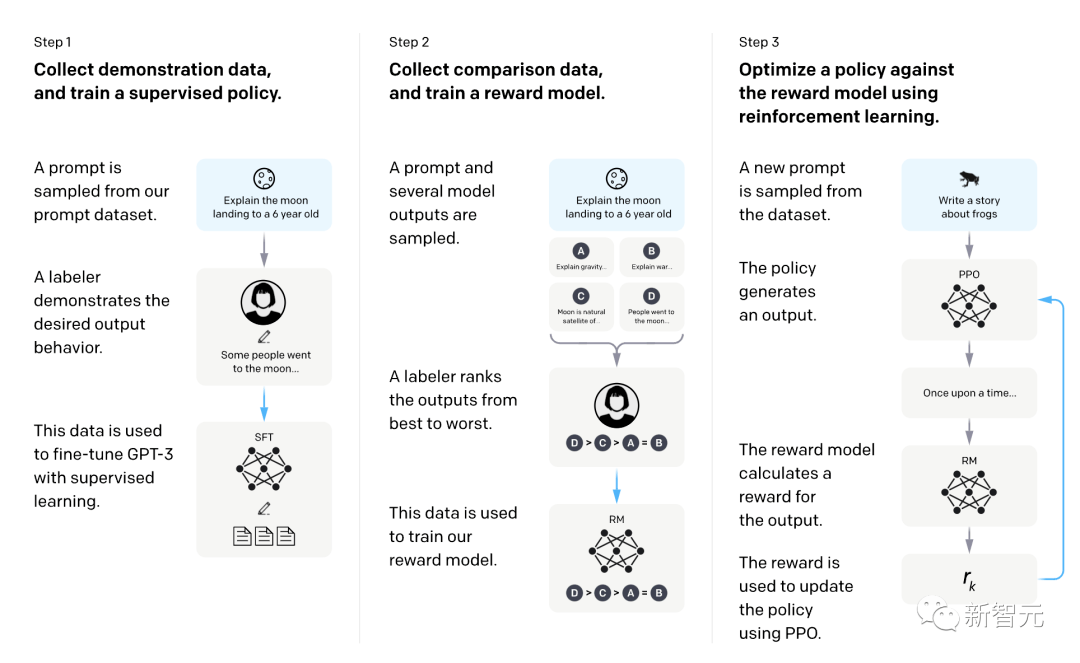

具体来说,RLHF分为三步:预训练一个监督微调LLM;收集数据训练一个奖励模型;用RL微调模型。

有了RLHF,大模型可以针对复杂的序列级目标进行优化,而传统的SFT很难区分这些目标。

然而,一个非常现实的问题是,RLHF需要大规模高质量的人类标注数据,另外这些数据能否可以取得一个优胜的结果。

在谷歌这项研究之前,Anthropic研究人员是第一个探索使用AI偏好来训练RL微调的奖励模型。

他们首次在「Constitutional AI」中提出了RLAIF,发现LLM与人类判断表现出高度一致,甚至在某些任务上,表现优于人类。

但是,这篇研究没有将人类与人工智能反馈做对比,因此,RLAIF是否可以替代RLHF尚未得到终极答案。

谷歌最新研究,主要就是解决这个问题。

研究人员在模型摘要任务中,直接比较了RLAIF和RLHF。

给定1个文本和2个候选答案,使用现成的LLM给出一个偏好标注。

然后,根据LLM偏好和对比损失训练奖励模型(RM)。最后,通过强化学习微调策略模型,利用奖励模型给出奖励。

那么,谷歌与Anthropic提出的RLAIF方法有什么不同?

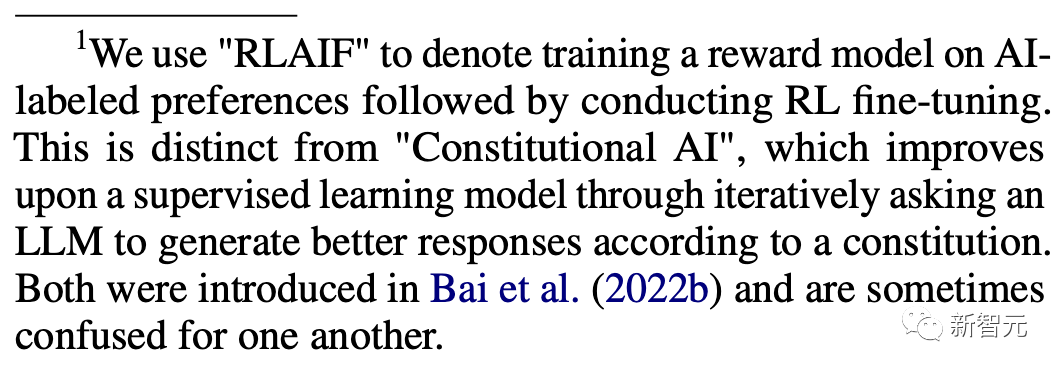

谷歌自己在文中解释道,

- 谷歌:根据AI标注的偏好训练奖励模型,然后进行RL微调。

- Constitutional AI:通过迭代,要求LLM根据宪法生成更好的响应,来改进监督学习模型。

AI自标注,自我改进

谷歌在最新研究中提出的RLAIF方法,过程是怎样的?

大语言模型进行偏好标注

研究人员用「现成的」LLM来标注对两个候选项之间的偏好。

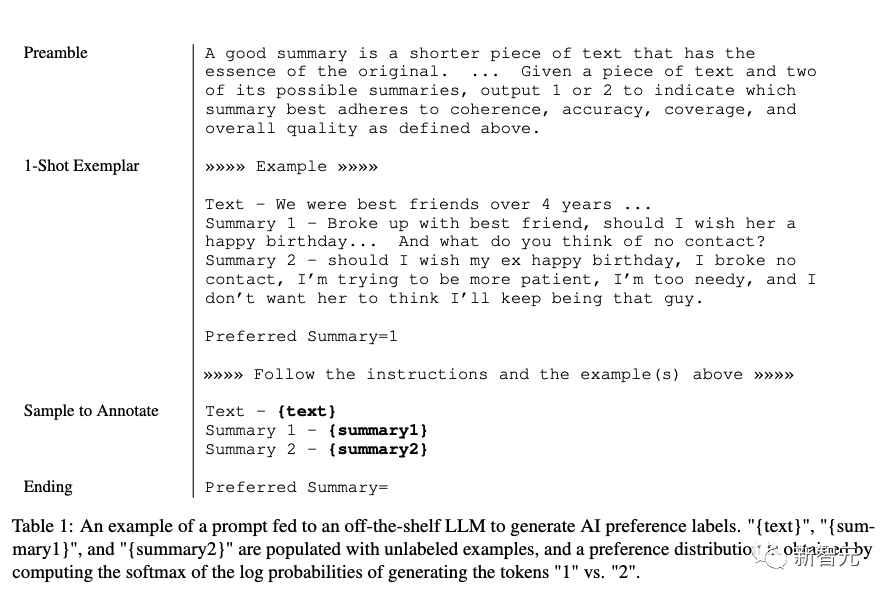

这是一个针对一般用途进行预训练或指令调整的模型,但未针对特定下游任务进行微调。给定一段文本和两个候选摘要,LLM被要求评价哪个摘要更好。LLM 的输入结构如下:

1. 序言

介绍和描述手头任务的说明

2. 多个样本实例(可选)

一段文本、一对摘要、思路的基本原理和偏好判断

3.要标注的样本

一段文本和一对要标注的摘要

4.结尾

提示 LLM 的结束字符串(例如「Preferred Summary=」)

在给LLM提供输入后,研究人员获得生成token「1」和「2」的对数概率,并计算softmax以获得偏好分布。

从LLM获取偏好标注的方法有很多,例如从模型中解码自由形式的响应并启发式地提取偏好(例如:output=「the first summary is better」),或者将偏好分布表示为单热表示(one-hot representation)。然而,研究人员没有尝试这些替代方案,因为他们的方法已经产生了很高的准确性。

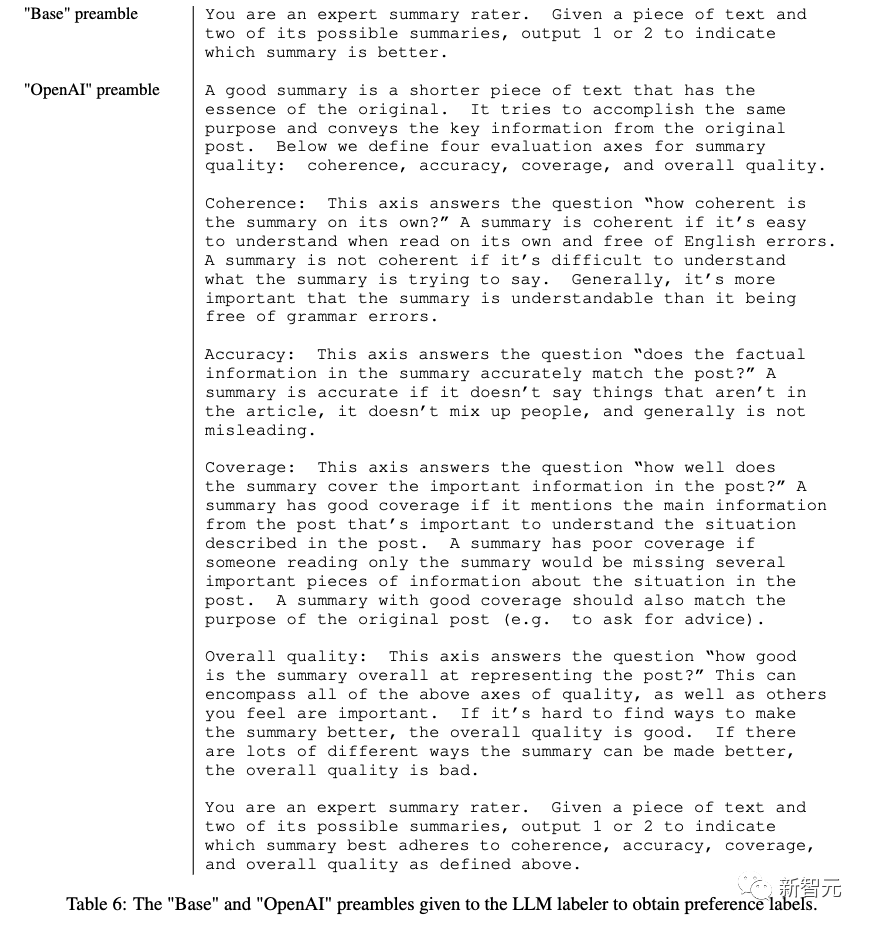

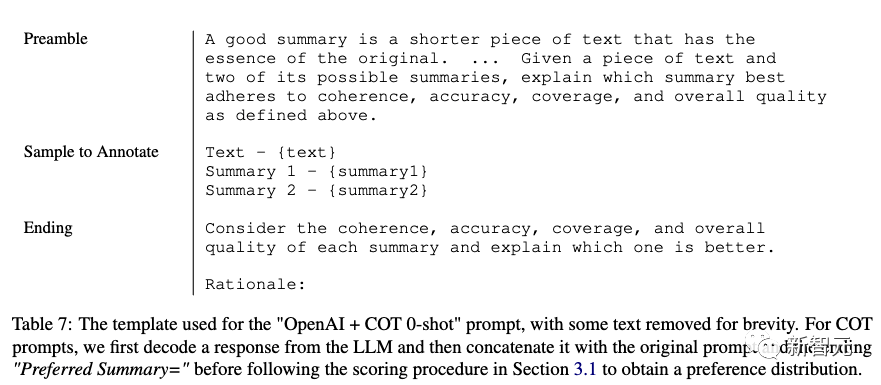

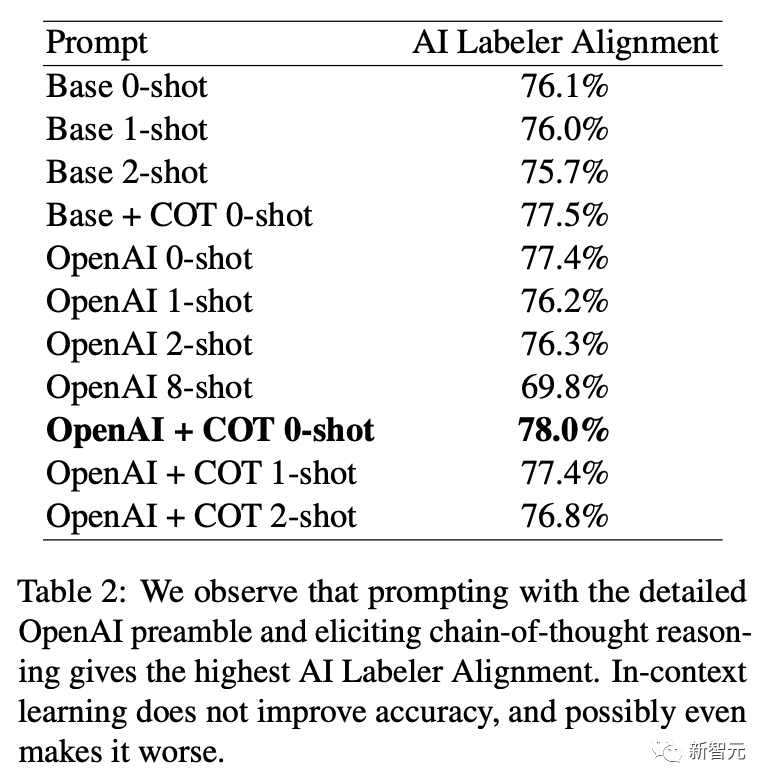

研究人员试验了两种类型的序言:第一种是「Base」,它简单地询问「哪个摘要更好?」,第二种是「OpenAI」,它模仿了生成OpenAI TL;DR 偏好数据集的人类偏好标注器的评级指令,包含有关构成强摘要的详细信息。如下图所示。

研究人员还通过在提示中添加少量样本来尝试上下文学习,其中手动选择样本来涵盖不同的主题。解决位置偏差。

之前的研究结果表明,向LLM展示候选项的顺序可能会影响LLM判断更喜欢的候选项。研究人员发现证据表明存在这种位置偏差,尤其是对于较小尺寸的标注LLM 。

为了减轻偏好标注中的位置偏差,研究人员对每对候选项进行两次推理,候选项提交给LLM的顺序二次推理是相反的。然后对两个推推理的结果进行平均以获得最终的偏好分布。

思维链推理

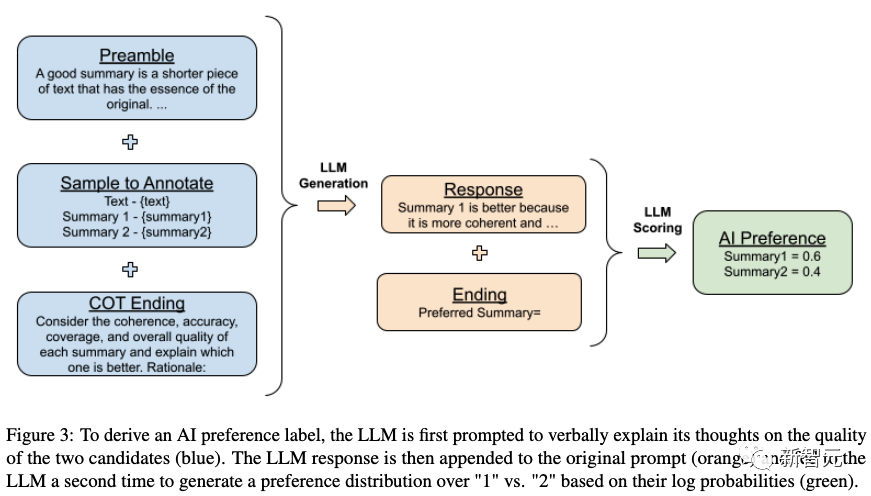

研究人员尝试从AI标注器中引出思维链 (COT) 推理,以提高与人类偏好的一致性。

研究人员替换标准的结尾提示(例如将「Preferred Summary=」替换为「Consider the coherence, accuracy, coverage, and over-all quality of each summary and explain which one is better. Rationale:」),然后解码一个LLM的回复。

最后,研究人员将原始提示、响应和原始结尾字符串“Preferred Summary=”连接在一起,并按照第 3.1 节中的评分过程来获得偏好分布。具体过程见下图。

在零样本提示中,LLM没有给出推理应该是什么样子的示例,而在少量样本提示中,研究人员提供了模型要遵循的COT推理示例。示例请参见下图。

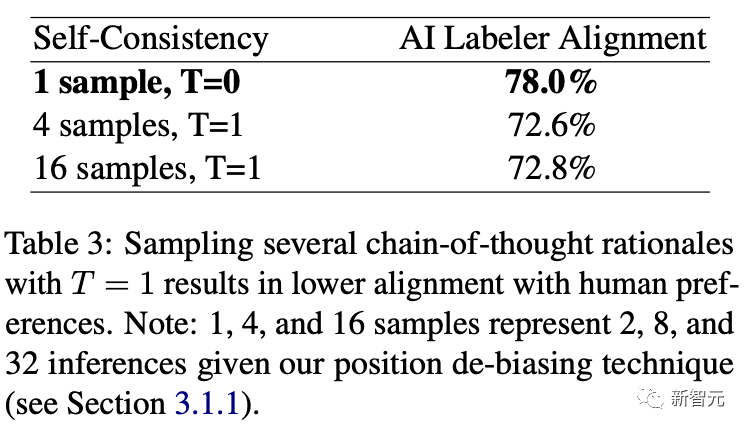

自洽性(Self-Consistency)

对于思维链提示,研究人员还尝试了自洽性——一种通过对多个推理路径进行采样并聚合每个路径末尾产生的最终答案来改进思维链推理的技术。

使用非零解码温度(non-zero decoding temperature)对多个思维链基本原理进行采样,然后按照上一节中的方法获得每个思维链的LLM偏好分布。然后对结果进行平均以获得最终的偏好分布。

AI反馈的强化学习

在LLM对偏好进行标注后,将训练奖励模型(RM)来预测偏好。由于研究人员的方法产生软标注(Soft Label),他们采用RM生成的奖励分数的softmax的交叉熵损失(cross-entropy loss),而不是奖励模型中提到的损失。

Softmax将RM的无界分数(unbounded scores)转换为概率分布。

在AI标注数据集上训练RM可以被视为模型蒸馏的一种形式,特别是因为研究人员的AI标注器通常比RM更大、更强。

另一种方法是绕过RM并直接使用AI反馈作为RL中的奖励信号,尽管这种方法的计算成本更高,因为AI标注器比RM更大。

通过经过训练的RM,研究人员使用适用于语言建模领域的Advantage Actor Critic (A2C)算法的修改版本进行强化学习。

评价

研究人员通过三个指标评估他们的结果 - AI标注器对齐、配对准确度和胜率。

AI标注器对齐时用来衡量AI标注偏好相对于人类偏好的准确性。

对于单个示例,将软人工智能标注的偏好转换为二进制表示。如果标注与目标人类偏好一致则分配 1,否则分配 0。

配对准确性是衡量经过训练的奖励模型相对于一组保留的人类偏好的准确性。

给定共享上下文和一对候选响应,如果根据人类标注,RM对首选候选的评分高于非首选候选,则配对准确度为 1。否则该值为 0。该数量是多个示例的平均值,以衡量RM的总体精度。

胜率通过衡量人类更喜欢一项策略频率来评估两项策略的端到端质量。

给定一个输入和两次生成结果,人类标注者选择首选哪一个生成结果。策略A优于策略B的实例百分比称为「A对B的胜率」。

实验细节

研究人员使用由OpenAI管理的经过过滤的Reddit TL;DR 数据集。TL;DR包含来自Reddit的约300万个帖子,涉及各种主题(也称为「subreddits」)以及原作者撰写的帖子摘要。

数据还经过OpenAI过滤,以确保高质量,其中包括使用普通大众可以理解的Reddit主题白名单。

此外,仅包含摘要中含有24到48个标注的帖子。过滤后的数据集包含123,169个帖子,其中约5%作为验证集。

有关数据集的更多详细信息可以在原始论文中找到。此外, OpenAI从过滤后的TL;DR数据集中整理了一个人类偏好数据集。

对于给定的帖子,根据不同的策略生成两个候选摘要,并要求标注器对他们喜欢的摘要进行评分。总数据集包含大约92k成对比较。

LLM标注

为了评估AI标注技术的有效性(例如提示、自洽性),研究人员从TL;DR偏好数据集中选择示例,其中人类标注者会偏好置信度更高的摘要。

研究人员在数据集训练分割的随机15%子集上评估AI标注器对齐,以实现更快的实验迭代,生成2851个评估示例。

对于奖励模型训练,TL;DR偏好数据集的完整训练分割由LLM标注并用于训练,无论置信度分数如何。

模型训练

研究人员使用PaLM 2 Extra-Small (XS)作为初始检查点,在OpenAI过滤后的TL;DR数据集上训练SFT模型。

然后,研究人员从SFT模型初始化RM,并在OpenAI的TL;DR人类偏好数据集上训练它们。

对于表1和5.1中的结果,研究人员使用PaLM 2L生成AI标注的偏好,使用「OpenAI + COT 0-shot」提示(,没有自洽性,然后在完整的偏好上训练RM数据集。

对于强化学习,研究人员使用Advantage Actor Critic (A2C)来训练策略。策略和价值模型都是从SFT模型初始化的。研究人员使用过滤后的 Reddit TL;DR 数据集作为初始状态来推出他们的策略。

人类评估

研究人员收集了1200个人类评级来评估RLHF和RLAIF策略。对于每项评级任务,评估人员都会收到一篇帖子和4个根据不同策略(RLAIF、RLHF、SFT和人类参考各一个)生成的摘要,并要求按照质量顺序对它们进行排名,不存在任何联系。

帖子取自TL;DR监督微调数据集的保留集,该数据集未用于任何其他评估。一旦收集了这些排名,就可以计算任意两项策略的胜率。

胜率50%,打平手

RLAIF vs. RLHF

文章开篇,已经介绍了谷歌将RLAIF与RLHF相比较的优势,结果表明,两种方法有着相似的性能。

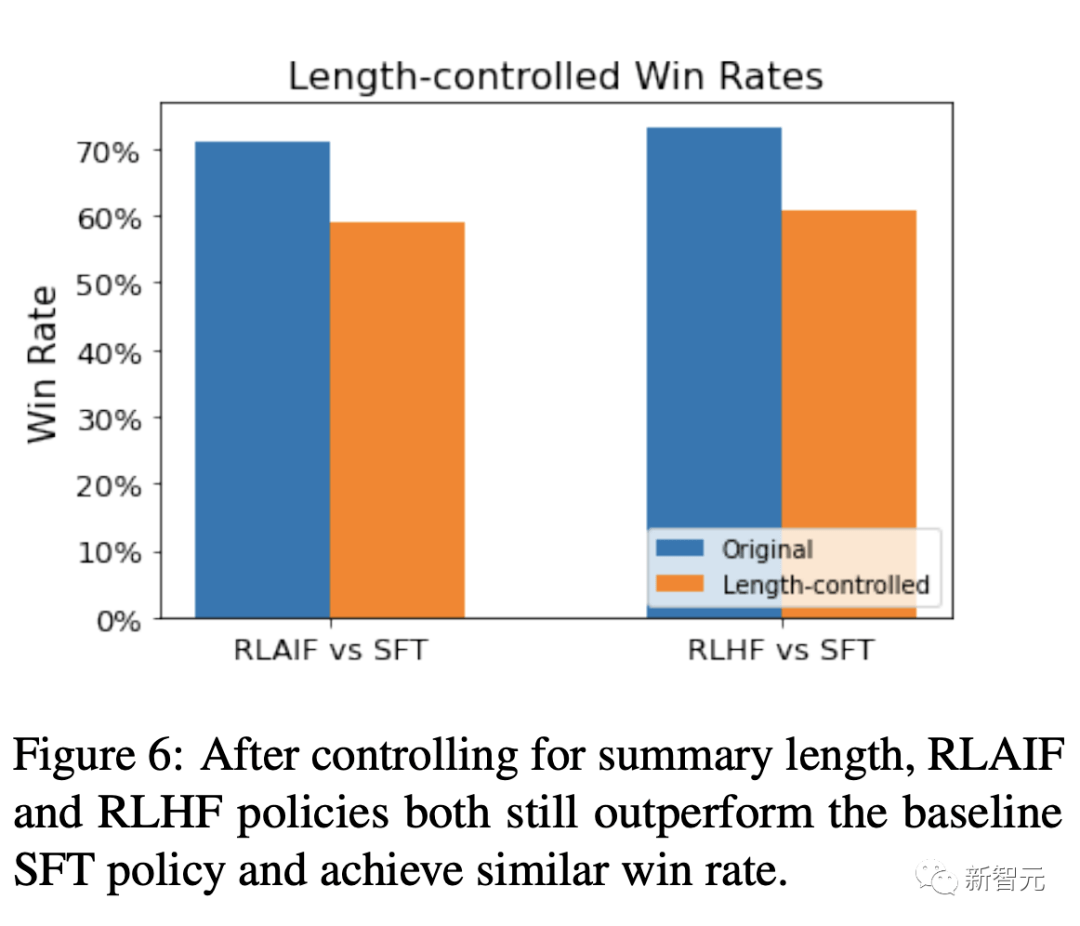

具体来说,与基线SFT相比较,在71%的情况下,人类评估者更喜欢RLAIF。73%的情况下,RLHF优于SFT。

研究人员还直接比较了RLAIF和RLHF的胜率,发现它们受欢迎程度是等同的——即胜率都是50%。

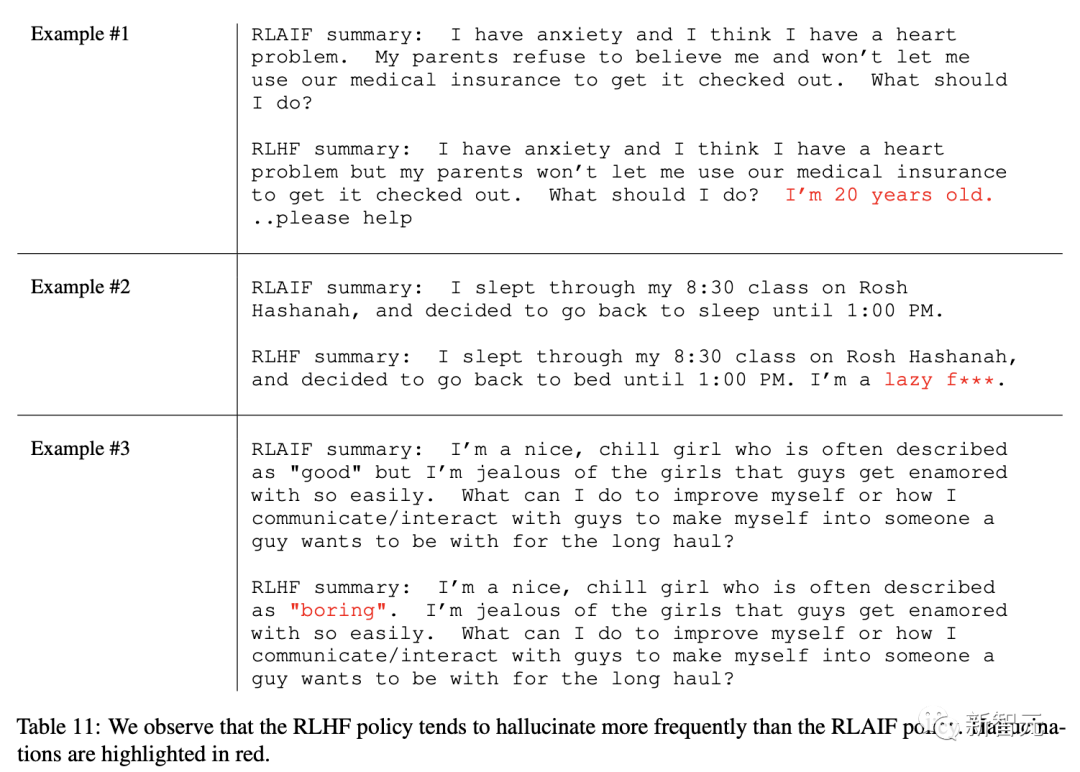

为了进一步了解这两种策略的差异,谷歌对其生成的摘要进行了定性比较。

另外,他们还将RLAIF和RLHF摘要与人工编写的参考摘要进行比较。79%的情况下,RLAIF生成的摘要优于参考摘要,80%的情况下,RLHF结果优于参考摘要。

可见,RLAIF和RLHF与参考摘要之间的胜率只差1%,并没有显著的差异。

值得注意的是,研究人员还发现,RLHF策略出现幻觉的频率,往往高于RLAIF,如上表红色标注的文字。

在控制摘要长度后,RLAIF和RLHF策略仍然优于基线SFT,并取得了相似的胜率。

这些结果表明,RLAIF不需要依赖于人工标注,是RLHF的可行替代方案。

提示技巧

在使用提示技巧中,谷歌团队尝试了三种类型的提示技术,preamble specificity、CoT、少样本上下文学习。

结果发现,通过详细的OpenAI序言进行提示,并进行CoT推理,AI标注器可以取得78%的一致性。

而情境学习不会提高准确性,甚至可能会使准确性变得更糟。

自洽性

研究人员使用4和16个样本进行自洽性实验,解码温度为1。

以T = 1对多个思维链原理进行采样,结果与人类偏好的一致性较低。

大模型标注器的规模

研究还发现,扩大大模型标注器的参数规模,可能会产生更高质量的偏好标注。

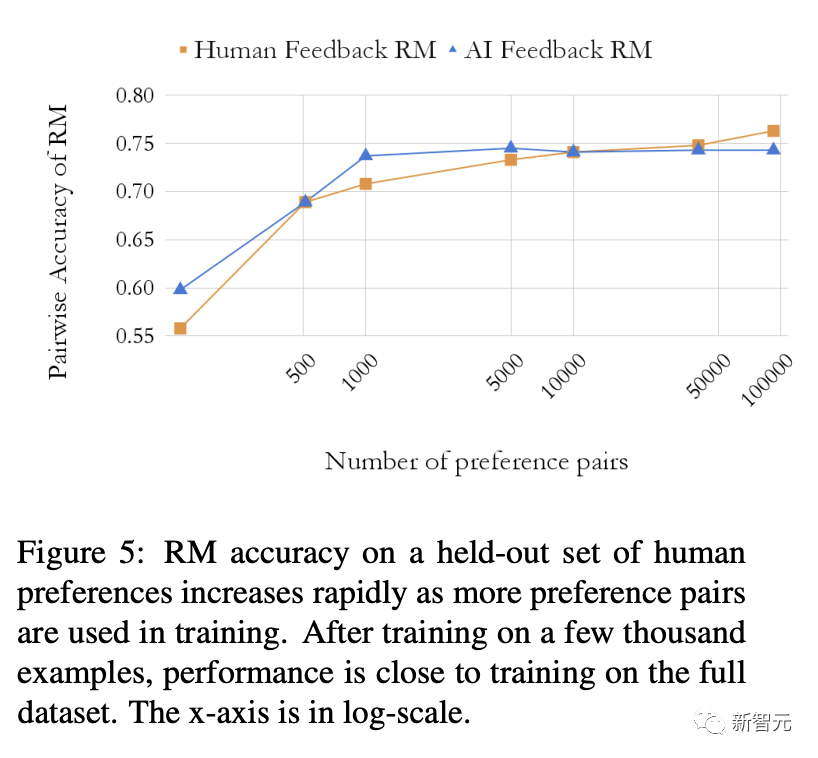

偏好示例数量

奖励模型的准确性如何随训练示例进行变化?

研究人员发现,需要经过数千个示例训练后,奖励模型的性能接近于完整数据集的训练。

结论

研究人员证明了RLAIF可以在不依赖人类标注者的情况下产生与RLHF相当的改进。

虽然这项工作凸显了 RLAIF 的潜力,但依然有一些局限性。

首先,这项研究仅探讨了总结任务,关于其他任务的泛化性还需要进一步研究。

其次,研究人员没有估计LLM推理在经济成本上是否比人工标注更有优势。

此外,还有一些有趣的问题值得研究,例如RLHF与RLAIF相结合是否可以优于单一的一种方法,使用LLM直接分配奖励的效果如何,改进 AI标注器对齐是否会转化为改进的最终策略,以及是否使用LLM与策略模型大小相同的标注器可以进一步改进策略(即模型是否可以「自我改进」)。

网友热议

谷歌发表了两篇关于RL的论文:

1. RLAIF:训练与人类反馈类似的奖励模型

2. ReST:使用生成模型促进自训练 将这两篇论文结合起来,可以满足那些对数据饥渴的人工智能算法

半个月前,谷歌DeepMind刚刚提出了一个新算法ReST,为了使大规模语言模型与人类偏好保持一致。

具体通过离线强化学习方法,改进大型语言模型的翻译质量,以更好地符合人类偏好。

一位研究人员表示,根据定性测试,Anthropic的Claude模型似乎比GPT-4弱。这可能是RLHF/RLAIF方法或预训练造成的。目前还不清楚这些方法在实际应用中的泛化效果是否更好,即使它们在学术基准上的表现更好。

我不会说这降低了人工标注的重要性,但有一点可以肯定,人工智能反馈的RL可以降低成本。人工标注对于泛化仍然极其重要,而RLHF+RLAIF混合方法比任何单一方法都要好。

大部分网友认为论文是很大的突破,但也有网友觉得这和Anthropic在几个月前提出的Constitute Claude中的RLAIF似乎没有本质的区别。

参考资料:

https://arxiv.org/abs/2309.00267